Relatos de criadores, documentos vazados e pesquisas mostram que, mesmo sem listas públicas, as plataformas influenciam quais vozes ganham alcance — e usuários aprendem a contornar o que chamam de “algospeak”.

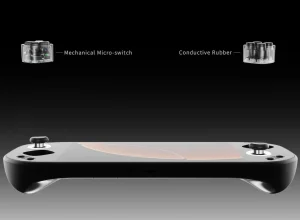

Nas redes sociais virou prática comum evitar palavras ou nomes diretos e usar códigos para driblar o que os usuários acreditam ser punições automáticas dos algoritmos. Esse fenômeno é conhecido como “algospeak” — uma linguagem algorítmica criada por quem publica conteúdo para escapar de supostas limitações de alcance ou remoções.

O que é algospeak e por que ele surgiu

Algospeak descreve termos, eufemismos e artifícios linguísticos usados para evitar que uma postagem seja apagada, escondida ou perca alcance. A lógica que guia quem usa esse conjunto de códigos é simples: se uma palavra direta parece acionar moderação ou desmonetização, use outra expressão, um apelido ou referência indireta.

As grandes plataformas — TikTok, YouTube e Meta (Facebook/Instagram) — afirmam não manter listas fixas de palavras proibidas e dizem avaliar o contexto das publicações. Ainda assim, relatos de criadores e investigações jornalísticas sugerem que a moderação e os sistemas de recomendação agem, muitas vezes de forma opaca, sobre conteúdos sensíveis.

Exemplos reais: de “Homem da Ilha” a “festival de música”

Caso emblemático: o criador Alex Pearlman relata ter evitado pronunciar “YouTube” em vídeos no TikTok porque observou queda de desempenho sempre que pedia que seguidores visitassem seu canal. Pearlman também descreveu remoções de vídeos sobre Jeffrey Epstein no TikTok que permaneceram intactos no YouTube e no Instagram — sem explicação clara das normas violadas.

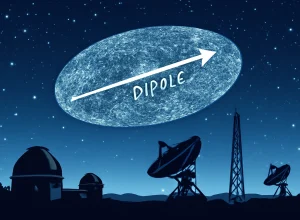

Em outra situação, manifestações nos EUA acabaram sendo descritas por muitos criadores como um suposto “festival de música”. A expressão virou um código para falar sobre protestos, numa tentativa de escapar da suposta supressão algorítmica; ironicamente, o termo tornou-se viral e criou o que pesquisadores chamam de “imaginário algorítmico” — crenças que fazem as pessoas agir de determinada forma online, independentemente de a supressão realmente ocorrer.

Vazamentos, processos e a existência de um “botão secreto”

Documentos vazados e ações judiciais já mostraram práticas controversas. Em 2019, vazamentos indicaram que moderadores do TikTok receberam instruções para suprimir conteúdos considerados “menos atraentes”, incluindo material de usuários pobres, com deficiência ou LGBTQIA+. Na sequência, a plataforma disse que a prática não era adotada como rotina.

Também vieram à tona relatos de ferramentas internas para impulsionar determinados posts — um “botão” que tornaria vídeos virais para favorecer parcerias ou interesses comerciais. O TikTok admitiu, em 2023, a existência dessa ferramenta para promover conteúdos específicos, o que alimentou a suspeita lógica: se há um botão para amplificar, haveria meios para “esfriar” ou suprimir.

No YouTube, criadores já alegaram que termos como “gay” e “trans” levaram à desmonetização de conteúdos; ações nesse sentido foram, em alguns casos, rejeitadas nos tribunais, enquanto a plataforma mantém que não há proibição de palavras, apenas análise de contexto e políticas de anúncios.

Por que as plataformas agem assim (ou parecem agir)

Especialistas citados em reportagens apontam que a motivação central é econômica: redes sociais dependem de publicidade e buscam ambientes atrativos para anunciantes, além de quererem manter usuários e evitar atritos com reguladores. Assim, moderação e recomendação servem para equilibrar o conteúdo exibido com o objetivo de manter audiência e receita.

Sarah T. Roberts, pesquisadora da UCLA, alerta para a opacidade das regras: decisões automatizadas e manuais de moderação raramente são explicadas de modo compreensível ao usuário comum. Isso cria espaço para teorias e estratégias de contorno por parte de criadores, que testam termos e formatos para descobrir o que o algoritmo favorece.

Consequências: autocensura, fragmentação do discurso e desigualdade de alcance

A prática do algospeak leva a dois efeitos principais. Primeiro, gera autocensura: criadores que temem perder alcance optam por evitar temas polêmicos ou por tratá‑los com eufemismos, reduzindo o debate público direto. Segundo, pode aprofundar desigualdades de visibilidade: vozes menos favorecidas, comunidades marginalizadas ou pautas incômodas correm maior risco de ver seu alcance reduzido, intencionalmente ou não.

Criadores como Ariana Jasmine Afshar relatam ter alterado linguagem para driblar moderação, mas também reconhecem que o próprio sucesso de conteúdos políticos indica que as plataformas permitem discussão controversa — embora de forma inconsistente e sujeita a mudanças súbitas.

O que isso significa para quem consome e produz conteúdo

- Para produtores: o ambiente é de tentativa e erro; códigos e eufemismos podem aumentar alcance, mas também diminuem a clareza do debate.

- Para consumidores: notícias e mobilizações podem chegar veladas ou fragmentadas; é preciso checar contexto e fontes além dos códigos usados nas postagens.

- Para a sociedade: a dependência dessas plataformas como canal central de comunicação exige reflexão sobre se esse modelo é o melhor para participação pública e informação.

Reportagens da BBC, investigações de organizações como a Human Rights Watch e vazamentos anteriores mostram que, mesmo sem listas públicas de proibições, as plataformas influenciam silenciosamente quais conteúdos prosperam. A resposta das empresas muitas vezes reafirma políticas baseadas em contexto e segurança, mas a opacidade alimenta práticas culturais de algoritmos e linguagens codificadas.

Em suma: não existe um dicionário oficial do que não se pode dizer, mas a experiência coletiva de criadores e as evidências públicas apontam para um efeito real — e muitas vezes invisível — dos sistemas de moderação e recomendação sobre o que chega ao público.

Este artigo foi elaborado a partir de apuração e relatos compilados em matéria da BBC sobre algospeak e moderação nas redes sociais.